1. 서 론

2. 대상교량 및 드론

2.1 대상교량 및 드론 제원

3. 드론 촬영 영상 및 후처리

3.1 드론 촬영 영상

3.2 정사영상 제작

4. 인공지능 모델을 이용한 균열 분석

4.1 인공지능 모델 개요

4.2 인공지능 모델을 이용한 균열 분석

5. 결 론

1. 서 론

육안점검은 모든 점검방식 중 가장 광범위하게 사용되는 방식으로 손상에 대한 상세 점검 이전에 초기점검 방식으로 수행된다. 육안점검은 주기적인 점검을 통해 조사를 수행해야 하며, 구조물의 상태변화와 관련된 상태평가에 큰 비중을 차지한다. 그러나 높은 주탑을 가지는 해상특수교량은 특수한 구조적 특징으로 인해 육안점검이 어려운 점검사각지대가 존재하게 되고, 점검사각지대 중에 주탑 외부 균열은 정밀안전점검에서도 점검이 안되는 경우가 대부분이다(KICT, 2021). 또한 해상특수교량의 경우 안전점검을 수행하려면 점검자가 로프 등을 이용하여 주탑 외벽을 직접 점검해야 하므로 예산과 안전에 큰 문제가 발생하게 되며, 외관조사 상태평가 역시 점검자의 컨디션이나 주관에 의해 달라질 수 있으므로 객관적인 데이터의 확보에 어려움이 있다. 이런 문제점을 해결하고자 보다 안전하고 효율적이며 객관적인 안전점검을 위해 드론을 이용한 안전점검 방법이 계속해서 연구되고 있다.

KAIA(2020)에서는 연구사업을 통해 무인검사장비 기반 교량 구조물의 신속진단 및 평가 기술을 개발하여 기초적인 연구를 하였으며, Lee et al.(2022)은 해상특수교량의 안전점검 외관조사에 있어 드론을 활용하여 시설물 안전점검의 효율성을 높이기 위해 드론을 활용하여 교량 안전점검을 위한 표준절차 정립에 관한 연구를 진행하였다. Park et al.(2019)은 4차 산업혁명 시대를 맞이하여 구조물 안전진단에 드론이 활용되는 사례들을 기술하였으며, Yeo and Yu(2018)는 드론을 활용한 시설물 상태점검의 현황과 미래에 대해 고찰하였다. 드론이 보급되고 활용되면서 NGII(2018)에서는 무인비행장치를 활용하기 위한 공공측량 작업지침을 제시하기도 하였다.

또한 해상특수교량 주탑 표면 손상에 대해 인공지능을 이용하여 균열을 검출하고 분석하는 방법들이 연구되고 있다. Choi et al.(2021)은 균열의 분석 및 평가를 위해 UNET과 8개 과정의 사후처리 이미지 프로세싱을 통해 균열을 분리, 군집화, 분석 및 시각화하는 연구를 수행하였으며, Jung et al.(2019)은 기존 콘크리트 건축물에서 영상 기반 균열 검출 방법을 제시하고 드론 영상 기술과의 연계성 및 확장성을 고려한 균열 검출 방법을 제안하였다.

본 연구는 일상점검이 불가능한 해상특수교량 주탑부에 대해 드론을 이용하여 영상 데이터를 취득하고, 서로 다른 구조를 지닌 딥러닝 네트워크를 활용하여 앙상블을 형성한 모델을 구축하여 각 모델의 결과를 취합하는 스태킹 앙상블 학습법을 적용한 메타 모델을 적용하여 균열 탐지 방안을 연구하였다.

2. 대상교량 및 드론

2.1 대상교량 및 드론 제원

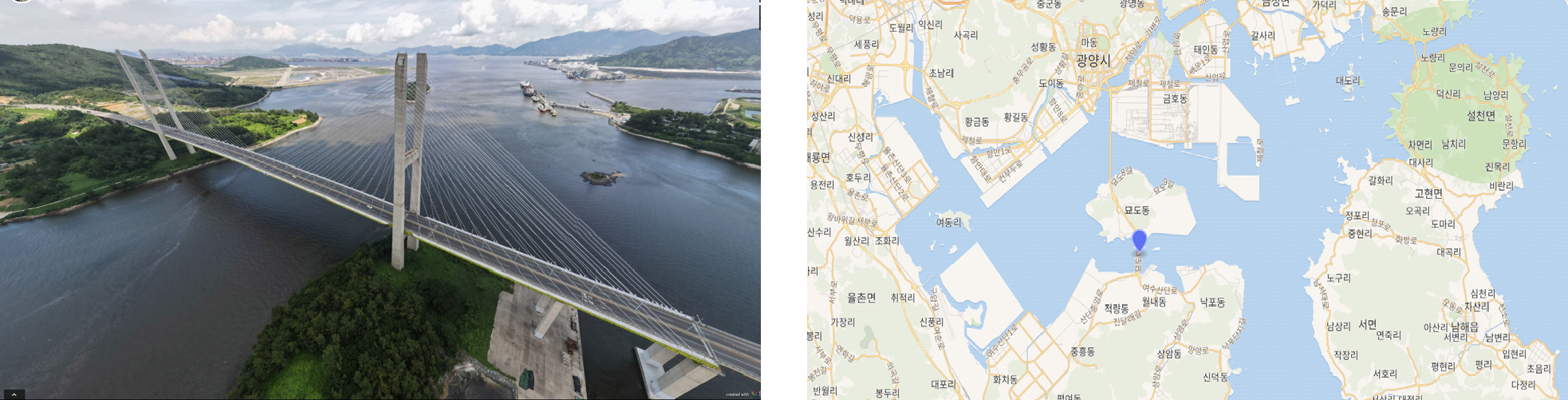

본 연구의 대상 교량은 묘도대교로서 전라남도 여수시 월내동 여수국가산업단지와 묘도동 사이를 잇는 사장교이다. 여수국가산업단지와 광양국가산업단지 간 물류비용 절감 및 2012 여수세계박람회의 원활한 진행과 한려해상 등 서남해안 관광 인프라를 개선하기 위하여 건립되었다. 묘도대교는 GS건설에서 2007년 10월 착공하여 2013년 2월 이순신대교와 함께 정식으로 개통하였고, 총공사비는 1,968억 원이 소요되었다. 교량 제원은 Table 1에 나타내었으며, 대상교량의 전경 및 위치를 Fig. 1에 나타내었다.

Table 1.

Outline of target bridge

| Division | Substance |

| Target bridge | Myodo bridge |

| Bridge type | Steel composite stayed-cable bridge |

| Length | 1,410 m |

| Width | 29.1 m |

| Main span length | 430 m |

| Construction year | 2013 |

본 연구의 수행을 위해 Intel사의 FalconTM 8+ 산업용 드론과 DJI사의 Matrice, Phantom 및 Mavic 드론을 이용하였다. 본 연구에 메인으로 사용한 드론과 카메라를 Fig. 2에 나타내었다. Intel FalconTM 8+ UAV는 2.8 kg의 무게로 비교적 다른 산업용 드론에 비해 가벼우며, 8개의 프로펠러 및 125 W 모터를 장착하여 프로펠러가 최대 2개의 손상에도 정상 주행이 가능하다. 전방에는 Sony A7R 풀프레임 카메라가 탑재되어 있으며, 0도부터 180도 이상의 시야각 확보가 가능하여 교량 하부와 댐, 수직구조물 촬영에 최적화 되어 있다. Sony A7R 풀프레임 카메라는 10 m 거리에 2 mm GSD(Ground Sample Distance) 미만으로 확보가 가능하고 70 m 상공에서도 0.98 cm GSD 미만으로 확보가 가능하다.

3. 드론 촬영 영상 및 후처리

3.1 드론 촬영 영상

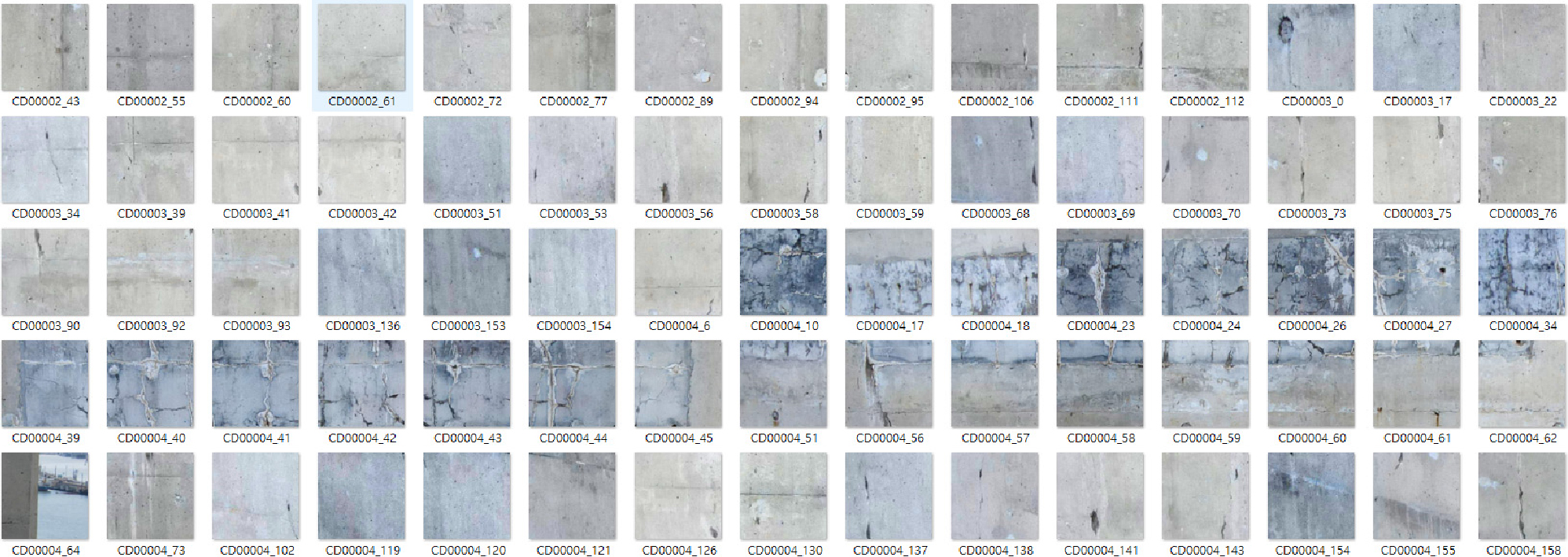

Fig. 3은 드론으로 촬영한 주탑의 대표 이미지를 보여주고 있다. 영상 데이터는 7,360 × 4,912 사이즈 34 MP 해상도로 수집되었으며, 주탑 2개소에 대해 총 3만여 장의 데이터를 취득하였다. 취득된 데이터 중 주탑-1에서는 총 137개의 균열 이미지를 수집하였으며, 주탑-2에서는 41개의 균열 이미지를 수집하였다.

3.2 정사영상 제작

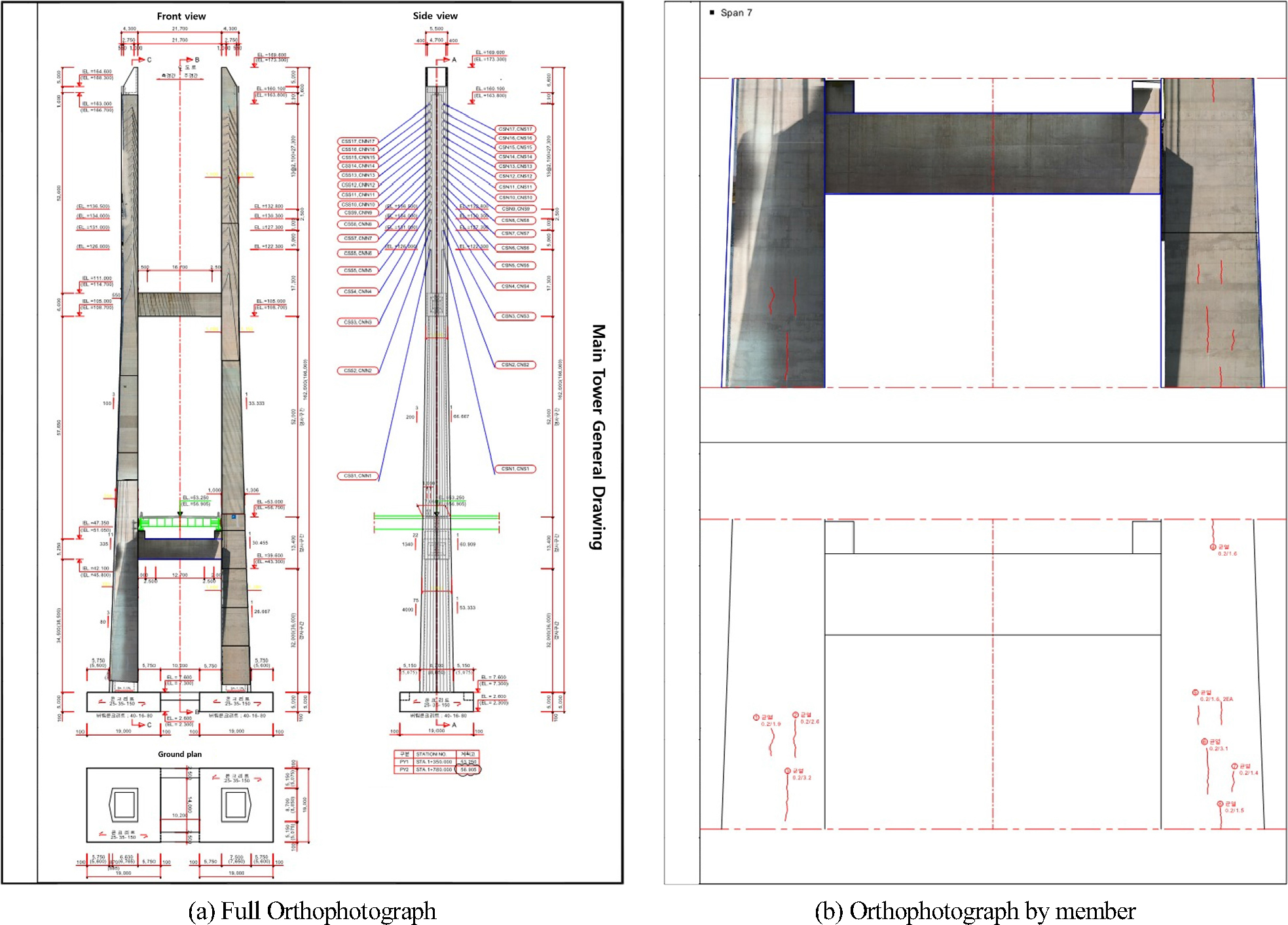

묘도대교 주탑의 드론 촬영 이미지는 Fix 4D 프로그램을 이용하여 후처리하여 정사영상 데이터 취득하였으며, 정사영상 데이터를 캐드 프로그램의 묘도대교 설계도면에 매칭시켜 외관조사망도를 작성하였다. Fig. 4는 묘도대교에 대한 전체 정사영상 데이터와 각 부재별 정사영상을 캐드도면에 매칭하여 나타낸 방법을 보여주고 있다.

4. 인공지능 모델을 이용한 균열 분석

4.1 인공지능 모델 개요

최근 시각 분야의 인공지능 모델은 Convolutional Neural Network(CNN)의 발전으로 빠르게 진화하고 있다. 건설 분야에서는 미세 균열을 감지하여 구조물 손상을 모니터링하고 관리하는 데 활용된다. Semantic segmentation models은 픽셀 단위의 균열 위치를 정확히 식별하여 사용되며, 특히 Fully Convolutional Network(FCN)은 기본적인 형태로서 성능이 우수하게 알려져 있다. 이 모델들은 두 가지 주요 아키텍처로 발전하였는데, 첫 번째는 encoder-decoder 형태의 U-Net과 그 파생체인 J-Net, M-net, UNet++, UNet3+, CU-Net 등이다. 이 아키텍처는 skip-connection을 활용하여 ensemble 효과를 극대화하고, 객체 간 미세 경계를 구분하는 데 높은 성능을 보인다. 두 번째 아키텍처는 DeepLabV1에서 V3까지의 네트워크로, 다양한 receptive field 크기의 pooling layer를 사용하여 특징을 추출하고, DeepLabV3 plus에서는 decoder 모듈을 추가하여 성능을 향상시켰다. 이 아키텍처는 일반적으로 적은 수의 파라미터를 사용하면서도 높은 세그멘테이션 품질을 제공한다. 또한 최근 attention module을 활용한 딥러닝 아키텍처로 double attention, OCR net, DAnet 등이 있으며, 자연어 처리에서 높은 성능을 나타내고 시각 분야로도 활용이 확장되고 있다. 본 연구에서는 의미론적 분할모델인 DeepLabV3, DeepLabV3+, UNet, DA-Net 4가지 모델의 성능을 비교하고, ensemble 기법을 활용하여 분할 성능을 개선도를 검토하였다.

본 연구에서는 4가지 모델을 ensemble 기법을 활용하여 meta 모델을 구현하였다(Lee et al., 2023). Meta 모델의 구조를 Fig. 5에 나타내었으며 이 모델이 구동하는 방법은 다음과 같다. 입력 이미지는 224 × 224 해상도의 3채널 RGB color 영상이며, 입력된 값은 4개의 서로 다른 종류의 모델에 입력된다. 4개의 서로 다른 종류의 모델은 4개의 개별 모델로 구성되며, 개별 모델은 각 4개의 폴드로 나눈 학습데이터에서 각 폴드를 검증셋으로 하는 4-fold cross validation 기법을 적용하였다. 크로스 벨리데이션이란 데이터 셋을 k번 쪼개서 반복적으로 쪼갠 data를 train과 test에 이용하여 교차 검증하는 방법이며 이는 동일한 원본 데이터를 가지고 학습을 진행하였기 때문에 모델의 과적합을 방지하고자 함이다.

각 종류별 4개의 모델을 통과한 값은 입력 이미지와 동일한 해상도에 2채널로 균열의 유무가 one-hot encoding 되며, 각 종류별 출력값은 (224 × 224 × 2) × 4의 형태를 지닌다. 각 종류별 224 × 224 × 2의 형태인 4개의 출력값은 동일 채널별로 픽셀값마다 평균을 내어 224 × 224 × 2 형태로 계산한다. 서로 다른 모델이 출력한 4개의 224 × 224 × 2 크기의 텐서는 채널방향으로 연결하여 224 × 224 × 8 텐서로 만들어진다. 224 × 224 × 8 크기의 텐서는 메타 모델의 입력값으로 사용되며, 메타모델은 최종적으로 입력 이미지와 동일한 해상도에 2채널 이미지 상의 균열의 유무가 one-hot encoding 된 224 × 224 × 2의 출력값을 산출한 형태를 지닌다.

7개의 공개된 균열 레이블링 데이터셋 및 1개의 비균열 데이터셋 총 11,298장을 사용하여 알고리즘을 학습시켰다. 학습에 사용된 데이터의 비율 Train : Validation : Test는 7:2:1이다. 개별 알고리즘 학습결과를 Fig. 6에 나타내었다. Input 이미지는 입력된 원본 이미지이고, Target 이미지의 흰색으로 표기된 부분이 알고리즘이 균열이라고 인식해야 하는 정답지이다. 나머지 Model 1~4의 모델이 16회 추론한 결과를 나타낸다. 각 모델의 특징에 따라 감지하는 형태가 다르게 나타나는 것을 알 수 있다. DANet의 Model 1~3은 균열 인식이 잘되고 있지 않았으나 Model 4에서는 균열 부위를 선명히 표시하고 있다. DeepLab V3은 비교적 균열을 잘 나타내었으나, DeepLab V3+는 균열부위 주변을 물방울처럼 표현하였다. UNet은 4가지의 모델 중에서 균열부위를 가장 잘 표현하였다.

4.2 인공지능 모델을 이용한 균열 분석

메타 모델 알고리즘을 이용하여 실제 해상교량 주탑부 취득 데이터의 균열 예측을 실시하였다. 원본 이미지는 4 K 해상도를 가지는 드론 영상 데이터를 사용하였으며, 주탑부에서 발생한 균열 영상 데이터를 224 × 224 해상도로 나누어 Fig. 7과 같이 1,235장에 대하여 테스트를 진행하였다.

메타 모델을 이용하여 실제 해상교량 주탑부 취득데이터의 균열 예측을 실시한 결과를 Fig. 8에 나타내었다. 대상 알고리즘의 성능평가지표는 객체검출의 정확도를 평가하는 일반적인 지표인 IoU(Intersection over Union)를 사용하였다. 묘도대교 데이터셋을 비학습 시킨 상태에서 IoU = 0.6155로 측정되어 일반적인 검출 기준인 IoU = 0.5 이상으로 나타나 충분한 성능을 나타내는 것으로 판단된다.

5. 결 론

본 연구에서는 전라남도 여수시에서 공용 중인 해상특수교량인 묘도대교를 대상으로 드론을 활용하여 주탑 표면에 대한 영상 데이터를 취득하여 객관적으로 손상을 판단할 수 있는 데이터를 구축하였다. 또한 서로 다른 구조를 지닌 딥러닝 네트워크를 활용하여 앙상블을 형성한 모델을 구축하여 각 모델의 결과를 취합하는 스태킹 앙상블 학습법을 적용한 메타 모델을 개발하고 이를 묘도대교에서 얻어진 균열 데이터에 적용하여 균열 손상을 평가하였다. 평가 결과 메타 모델의 평가 결과가 개별 모델의 평가 결과보다 우수한 것을 확인할 수 있었으며, 향후 더 많은 교량에 대한 데이터를 수집하고 알고리즘 모델을 학습시켜 정확도를 높이는 것이 필요하다.